آینده سئو تکنیکال دیگر به چکلیستهای تکراری محدود نیست. در دوران اتوماسیون، «مهندس سئو» باید یک سیستمساز باشد؛ کسی که بین معماری فرانتاند، زیرساخت، محتوا و داده پل میزند و با اتکا به پایپلاینهای CI/CD، پایش لاگها و کنترل کیفیت خودکار، ریسکهای سئو را قبل از رسیدن به کاربر مهار میکند. در بازار ایران که سرعت تغییر تکنولوژی بالاست و تیمها بهصورت اسپرینتی محصول عرضه میکنند، برنده کسی است که سئو را در جریان توسعه ادغام کند، نه بعد از آن. در این مقاله نقشهای جدید SEO Engineer در ۲۰۲۶ را با محور اتوماسیون، دادهمحوری و همکاری بینتیمی مرور میکنیم.

آینده سئو تکنیکال در دوران اتوماسیون: از چکلیست تا مهندسی سیستم

مسئله اصلی این است: سئو تکنیکال از «انجام کارها» به «طراحی سیستم» تغییر ماهیت داده است. بهجای اصلاح دستی تگها یا پیگیری موردی خطاها، مهندس سئو باید گذرگاههایی بسازد که کیفیت سئو را در لحظه اندازه بگیرند، خطاها را هشدار دهند و حتی جلوی ادغام کد مشکلساز را بگیرند. این تغییر، مهارتی فراتر از ابزارشناسی میخواهد: فهم معماری رندر، بودجه خزش، رفتار رباتها، و زیرساخت اندازهگیری. در شرکتهای ایرانی که با محدودیت منابع و سرعت بالای تغییرات روبهرو هستند، این رویکرد به کاهش هزینههای بازکاری، سرعت عرضه و پایداری رتبهها کمک میکند.

- هدف: ساخت «سامانه سئو» بهجای اجرای پراکنده تسکها.

- اصل طلایی: هر چیزی که دو بار انجام میدهید، باید خودکار شود.

- وضع مطلوب: سئو در Definition of Done هر فیچر تعریف شود.

«سئو تکنیکال ۲۰۲۶ یعنی مهندسی سیستم؛ جایی که کیفیت سئو، خروجی پیشفرض فرآیند توسعه است، نه نتیجه اصلاحهای بعدی.»

معماری Crawlability و Renderability در وبهای مدرن

انتخاب بین SSR، SSG، ISR و Edge Rendering فقط تصمیم فرانتاند نیست؛ تصمیمی سئویی است. باید دید ربات چگونه خزش میکند، چه چیزی را رندر میبیند و چطور بهروزرسانیها را کشف میکند. در پروژههای محتوامحور (بلوغ بالا، ترافیک ارگانیک زیاد)، SSG/ISR معمولاً پایدارترین عملکرد را دارد؛ در وباپلیکیشنهای تعاملی، SSR/Edge با استریمینگ و کش تهلبه سریعتر است. این جدول، مقایسه فنی-سئویی معماریها را نشان میدهد.

مقایسه SSR/SSG/ISR/Edge از منظر سئو

| معماری | خزشپذیری | رندرپذیری | تازگی محتوا | ریسک سئویی | موارد مصرف پیشنهادی |

|---|---|---|---|---|---|

| SSR | بالا؛ HTML اولیه کامل | خوب؛ JS پس از بارگذاری | فوری با رندر سرور | متوسط؛ هزینه سرور/Cache miss | وباپلیکیشنهای داینامیک، صفحات دسته |

| SSG | بسیار بالا؛ فایل استاتیک | عالی؛ کمریسک | در بیلد بعدی | کم؛ ولی آپدیت کندتر | بلاگ/لندینگهای پایدار، مستندات |

| ISR | بالا؛ با بازتولید پسزمینه | عالی؛ با TTL کنترلشده | دقیق؛ طبق revalidate | کم؛ نیازمند تنظیم درست TTL | فهرست/جزییات محتوا با بهروزرسانی منظم |

| Edge Rendering | بالا؛ نزدیک کاربر/ربات | خوب؛ پیچیدگی دیپلوی | بسیار سریع با کش لبه | متوسط؛ هماهنگی CDN/قوانین | شخصیسازی سبک، رندر سریع منطقهای |

- راهنمای عمل: صفحات ایندکسی مهم را یا SSG/ISR کنید یا SSR با استریمینگ.

- برای JS-Critical، از Server Components/Partial Hydration استفاده کنید.

Core Web Vitals بهروز (LCP/INP/CLS) و مدیریت عملکرد در CI/CD

در ۲۰۲۶، INP جای FID را گرفته و تمرکز از تنها بارگذاری اولیه به «تعاملپذیری پایدار» جابهجا شده است. مهندس سئو باید بودجه عملکرد تعریف کند و آن را به CI/CD متصل سازد. پیشنهاد ما: Lighthouse CI + WebPageTest API برای تست آزمایشگاهی، و SDK وبوایتالز برای داده واقعی کاربر (RUM). هر PR باید در برابر بودجهها سنجیده شود و در صورت عبور از آستانهها، Merge مسدود گردد.

- LCP هدف: زیر ۲.۵ ثانیه در ۷۵امین صدک؛ INP زیر ۲۰۰ms؛ CLS زیر ۰.۱.

- بودجهها به مسیر/الگو وابسته باشد (Product Page vs. Blog Post).

- Regression Tests: تغییر فونت/اسکریپت/تصویر نباید CLS/LCP را بدتر کند.

- Feature Flags: تست A/B را با اندازهگیری وبوایتالز جفت کنید.

در ایران، نوسانات شبکه موبایل رایج است؛ پس به RUM اهمیت بدهید و نتایج را بر اساس نوع اتصال تفکیک کنید. تعریف KPIهای سئو و نقش آنها در رشد کسبوکار را میتوانید با چارچوبهای دادهمحور در استراتژی محتوایی و سئوی پیشرفته همسو کنید.

اسکیمای پیشرفته، موجودیتها و پیوند به گراف دانش

Schema.org دیگر فقط ستارههای ریویو یا FAQ نیست؛ محور «سئو موجودیتمحور» است. با مدلسازی موجودیتها (برند، محصول، نویسنده، مکان، رویداد) و اتصال آنها از طریق JSON-LD، به موتورهای جستوجو کمک میکنید معنا و نسبتها را بفهمند. کلید ماجرا consistency است: نام یکسان، شناسه یکتا، sameAs به منابع معتبر (از جمله ویکیدیتا/شبکههای رسمی)، و برBreadcrumb/Article/Organization استاندارد تکیه کنید.

- Pipeline اسکیمای خودکار: از مدل محتوا خروجی JSON-LD بسازید.

- Guardrails: اعتبارسنجی با Schematron/JSON Schema قبل از دیپلوی.

- Entity Linking: در متن داخلی، به صفحات موجودیت لینک دهید تا گراف داخلی ساخته شود.

- منوی مسیر: Breadcrumb با position صحیح و URLهای کانونی پایدار.

برای پروژههایی که میخواهند از «کلمهکلیدی» به «موجودیت و قصد» مهاجرت کنند، همترازی نقشه راه، KPI و اسکیمای مقیاسپذیر حیاتی است که در استراتژی محتوایی و سئوی پیشرفته قابل طراحی است.

اتوماسیون نظارت/هشدار: Log-based SEO، Crawl Budget و Anomaly Detection

وقتی سرعت توسعه بالا میرود، تنها راه دیدهشدن خطاها، اندازهگیری پیوسته است. تحلیل لاگهای وبسرور (Nginx/Apache) به شما نشان میدهد گوگلبات چه صفحاتی را میبیند، نرخ خطای ۴۰۴/۵xx چقدر است و آیا بودجه خزش به صفحات ارزشمند میرسد یا نه. این دادهها را به یک انبار (مثلاً دیتابیس ستونی) منتقل و روی آن داشبورد و هشدار بسازید.

- شاخصها: درصد بودجه خزش روی صفحات پولساز، میانگین Crawl Delay، نسبت ۲۰۰ به ۳۰۱/۴۰۴/۵xx.

- هشدارها: جهش ۴۰۴، افت ناگهانی ۲۰۰، تغییر الگوی User-Agent، robots misconfig، یا جهش زمان رندر.

- Anomaly Detection: از z-score/EWMA استفاده کنید تا نوسان فصلی با خطای واقعی اشتباه نشود.

- Jobهای زمانبندیشده: اعتبار نقشه سایت، حلقههای canonical، تست robots.txt، بررسی noindex ناخواسته.

نتیجه چنین سامانهای، کاهش ریسک انتشار و دید سریع به مشکلات است؛ قبل از اینکه در رتبهبندیها نمود پیدا کنند.

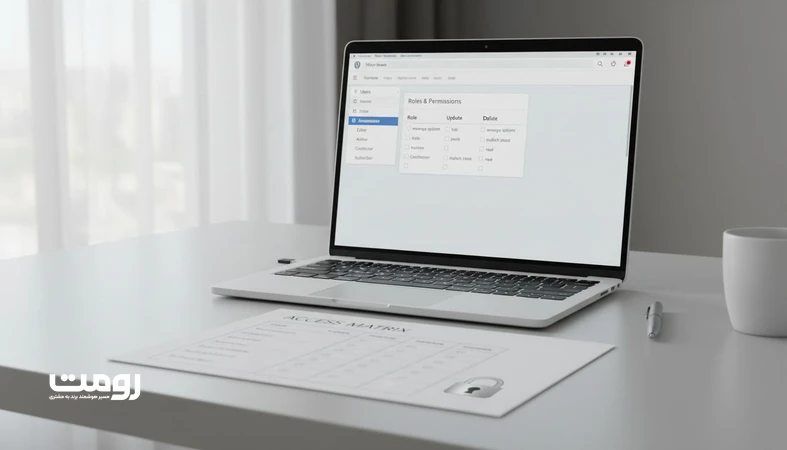

کنترل کیفیت محتوای تولیدشده با هوش مصنوعی: محافظهای تکنیکال

تولید خودکار محتوا بدون محافظ، بهسرعت به دوبارهکاری، محتوای نازک و تضاد سیگنالها منجر میشود. نقش مهندس سئو در ۲۰۲۶ تعریف و استقرار «Guardrail»های تکنیکال است تا هر محتوای جدید از منظر کانونیکال، لینکسازی داخلی و یکتا بودن امتیاز قبولی بگیرد. این محافظها باید در مرحله Preview/PR و قبل از ایندکس عمل کنند.

- Canonical Strategy: کانونیکال خوشهای؛ صفحه راهبر خوشه، مقصد کانونیکال داخلی باشد.

- Internal Linking: حداقل N لینک ورودی از صفحات همموضوع؛ چک گراف لینک داخلی قبل از انتشار.

- Duplication Guards: سنجش شباهت با embedding؛ اگر شباهت > آستانه، انتشار متوقف شود.

- Index Hygiene: noindex برای صفحات نازک، پارامتریک یا آزمایشی تا زمان تکمیل.

- Metadata QA: عنوان/دیسکریپشن یکتا؛ طول و کلیدواژه معنادار، بدون استافینگ.

در پروژههای بزرگ و چندتیمی، این محافظها باید بهصورت سیاست سازمانی و اتوماتیک اجرا شوند؛ برای مقیاس سازمانی، همکاری با تیمهای چندوظیفهای در طراحی وبسایت شرکتی کلیدی است.

ابزارها/مهارتها و تعامل بینتیمی: Git، Pipelines، Observability و تستهای رگرسیون

مهندس سئو ۲۰۲۶ یک «فولاستکِ کیفیت» است: با Git کار میکند، تست مینویسد، لاگ میخواند و با تیمهای Product/Content/Engineering یک زبان مشترک دارد. هدف این است که هر تغییر محصول، اثر سئویی قابل پیشبینی و قابل سنجش داشته باشد.

مهارتها و ابزارهای ضروری

- Git و CI/CD: خطمشی Branching، Code Review با چکهای خودکار سئو (Lighthouse CI، اسکیما ولیدیشن، لینکشکن).

- Observability: داشبوردهای وبوایتالز، ایندکسینگ، خطاهای رندر؛ هشدار لحظهای.

- تستهای رگرسیون سئو: واحد/یکپارچه برای robots.txt، sitemap، hreflang، canonical و ساختار Head.

- Data & Scripting: SQL برای تحلیل لاگ، اسکریپتنویسی برای خودکارسازی crawl و گزارش.

- فرهنگ همکاری: RACI شفاف، Acceptance Criteria سئویی در User Story، و حضور سئو در Design Review.

- نکات مهم: تعریف SLO سئو (مثلاً «LCP < ۲.۵s در ۸۰٪ ترافیک موبایل»)، بودجه خزش برای هر خوشه، و چرخه بازنگری فصلی KPI.

برای طراحی پشتهٔ سئو تکنیکال آیندهمحور، با رومت تماس بگیرید.

مهندس سئو در ۲۰۲۶، معمار کیفیت قابلاتکا

چشمانداز سئو تکنیکال در ۲۰۲۶ روشن است: مهندس سئو بهجای اجرای دستی، معمار سیستمهایی میشود که کیفیت سئو را خودکار تضمین میکنند. انتخاب معماری رندر بر پایه خزشپذیری، پایپلاینهای CI/CD با بودجه عملکرد، اسکیمای موجودیتمحور و نظارت مبتنی بر لاگ، هسته این تغییرند. در کنار آن، محافظهای تکنیکال برای محتوای تولیدشده با هوش مصنوعی و فرهنگ همکاری میان Product/Content/Engineering، سئو را از «وظیفه یک نفر» به «مسئولیت یک سیستم» ارتقا میدهد. اگر امروز این مسیر را آغاز کنید، فردا هزینه نگهداشت کمتر و رشد ارگانیک پایدارتری خواهید داشت.

سوالات متداول

۱. مهندس سئو در ۲۰۲۶ دقیقاً چه کاری میکند؟

تمرکز روی طراحی و پیادهسازی سیستمهای خودکار کیفیت سئو است: از انتخاب معماری رندر مناسب تا اتصال Core Web Vitals به CI/CD، اعتبارسنجی اسکیمای موجودیتمحور، پایش لاگها و تعریف محافظهای انتشار محتوا. او با تیمهای محصول، محتوا و مهندسی کار میکند تا اثر سئو در تعریف فیچرها دیده شود و ریسکها پیش از انتشار کنترل شوند.

۲. چرا ISR/SSG برای سئوی محتوامحور پیشنهاد میشود؟

بهدلیل تولید HTML استاتیک و رندر قطعی، رباتها با کمترین وابستگی به جاوااسکریپت محتوا را میبینند و ثبات عملکرد بالاست. ISR همزمان مزیت تازگی را با بازتولید پسزمینه میدهد. در نتیجه، هم سرعت بهتر است و هم ریسک رندر ناکامل کمتر میشود. البته باید TTL و قوانین کش را با الگوی انتشار محتوا هماهنگ کرد.

۳. چطور وب وایتالز را به فرآیند توسعه وصل کنیم؟

بودجه عملکرد تعریف کنید، در CI تست آزمایشگاهی (Lighthouse/WebPageTest) اجرا کنید و SDK وبوایتالز را برای داده واقعی کاربر به کار ببرید. اگر مقادیر از آستانه عبور کرد، ادغام کد مسدود شود. داشبوردهای RUM را بر اساس نوع دستگاه/شبکه تفکیک و تغییرات را با هر انتشار برچسبگذاری کنید تا علتیابی آسان شود.

۴. اسکیمای پیشرفته چه کمکی به رتبه میکند؟

اسکیما به موتور جستوجو میگوید «این صفحه درباره کدام موجودیت است و چه نسبتی با دیگر موجودیتها دارد». با JSON-LD استاندارد و لینکدهی sameAs، سیگنالهای معناشناختی تقویت میشود، شانس نمایش غنی بالاتر میرود و ناهمخوانی دادهها کاهش مییابد. اثر مستقیم اسکیمای درست، وضوح موضوعی و قابلیت کشف بهتر در نتایج است.

۵. چگونه کیفیت محتوای تولیدشده با هوش مصنوعی را تضمین کنیم؟

با تعریف محافظهای تکنیکال: کانونیکال خوشهای، حداقل لینکهای داخلی، پایش شباهت متنی با embedding برای جلوگیری از تکرار، و سیاست noindex برای صفحات نازک تا زمان تکمیل. همچنین متادیتای یکتا، ساختار heading صحیح و چکهای خودکار در مرحله PR قبل از انتشار، کیفیت را پایدار میکند و ریسک افت رتبه را کاهش میدهد.