هوش مصنوعی در برابر اسپم گوگل به مهمترین خط دفاعی وب تبدیل شده است. در سال ۲۰۲۶، سیستمهایی مانند SpamBrain و مجموعهای از الگوریتمهای یادگیری ماشینی با تحلیل الگوهای رفتاری، زبانی و پیوندی، محتوای جعلی و نتایج دستکاریشده را از نتایج جستوجو حذف میکنند. برای کسبوکارهای ایرانی، این روند به معنای ضرورت حرکت از تولید انبوه به تولید محتوای اصیل، دادهمحور و متکی بر تخصص واقعی است. این مقاله با چهار محور «تشخیص»، «پیشگیری»، «بازیابی» و «اعتماد» نشان میدهد چگونه ساختار فنی، استراتژی محتوایی و سیگنالهای برند شما باید بهروزرسانی شود تا در برابر الگوریتمهای ضداسپم مقاوم بمانید.

فهرست نکات برجسته

- SpamBrain همانند یک شبکه کشف الگو، سیگنالهای زبانی، رفتاری و پیوندی را ترکیب میکند.

- پیشگیری مؤثر یعنی همترازی تولید محتوا با دادههای واقعی، تخصص نویسنده و نیت جستوجوی کاربر.

- بازیابی سریع نیازمند ممیزی جامع، پاکسازی لینکها و بازنویسی هدفمند محتواست.

- اعتماد الگوریتمی از شفافیت برند، هویت معتبر و ساختار فنی سالم آغاز میشود.

تشخیص: گوگل چگونه محتوای اسپمی و جعلی را میبیند؟

در محور تشخیص، گوگل از مدلهای یادگیری ماشینی برای ترکیب چندین سیگنال استفاده میکند. ایده اصلی ساده است: هر زمان الگوهای غیرطبیعی و ناسازگار در زبان، لینکسازی، رفتار کاربر یا ساختار صفحات دیده شود، احتمال اسپم بالا میرود. SpamBrain مانند یک «فیوزن سنسوری» عمل میکند و خروجی مدلهای زبانی، تحلیل موجودیتها، همزمانی انتشار و الگوهای انکر تکست را کنار هم قرار میدهد تا تصمیمی مقاوم در برابر دستکاری بگیرد.

| سیگنال | نمونه الگوی مشکوک | راهحل ایمن |

|---|---|---|

| زبان و معناشناسی | تکرار بیمنطق کلیدواژه، جملات کلیشهای و ناسازگاری با واقعیت | استناد به دادههای واقعی، تنوع زبانی طبیعی، مثالهای بومی |

| لینکسازی | انبوه بکلینک از دامنههای بیربط، انکرهای یکشکل | کسب لینک موضوعی، انکر متناسب با محتوا، ذکر برند |

| رفتار کاربر | بانس بالا بلافاصله پس از ورود، عدم تعامل عمیق | بهبود UX، پاسخ سریع به نیت، ناوبری شفاف |

| ساختار فنی | صفحات نازک، تکراری، یا ایندکس شدن مسیرهای بیارزش | نازکزدایی، noindex هدفمند، کَنونیکال درست |

نکته کلیدی: گوگل صرفاً «محتوای تولیدشده با ابزار» را هدف نمیگیرد، بلکه «خروجی بیکیفیت و فریبنده» را حذف میکند. بنابراین تمرکز شما باید بر کیفیت و اصالت باشد، نه صرفاً ابزار.

پیشگیری: چگونه از پرچم اسپم دور بمانیم؟

چهار ستون پیشگیری

- تخصص و مرجعیت (E‑E‑A‑T): نمایش نویسندههای واقعی، رزومه و منابع شفاف. برای برنامهریزی هوشمند محتوا از چارچوبهای دادهمحور و استراتژی محتوایی استفاده کنید.

- مطابقت با نیت جستوجو: ساختاردهی محتوا بر اساس پرسشهای واقعی کاربر ایرانی، مثالها و قیمتها/قوانین محلی.

- کیفیت زبانی و شواهد: دادههای قابل بررسی، نقلقول بهجا، و پرهیز از اغراق. از محتوای تکراری یا ترجمهٔ خام دوری کنید.

- فنیِ سالم: سرعت بالا، هدینگهای معنادار، اسکیماهای مرتبط، جلوگیری از ایندکس صفحات بیارزش.

چکلیست پیشگیری سریع

- برای هر صفحه یک هدف روشن و یک «سوال اصلی کاربر» تعیین کنید.

- نویسنده و تاریخ بهروزرسانی را نمایش دهید؛ منابع را شفاف ذکر کنید.

- لینکسازی خارجی را محدود به منابع معتبر و مرتبط کنید.

- برای صفحات مشابه، کَنونیکال و noindex را دقیق تنظیم کنید.

- پایش دورهای الگوهای انکر تکست و رشد لینک را در گزارشها بگنجانید.

بازیابی: اگر با الگوریتمهای ضداسپم افت کردیم چه کنیم؟

بازیابی موفق یعنی پذیرش مسئله، مستندسازی دقیق و اقدام مرحلهای. عجله در حذف انبوه محتوا یا لینک بدون تحلیل، ریسک از دست دادن داراییهای سالم را بالا میبرد. مسیر زیر را بهصورت پیوسته اجرا کنید:

- ممیزی جامع محتوا: شناسایی صفحات نازک، تکراری، یا فاقد ارزش افزوده؛ ادغام/بازنویسی بهجای حذف شتابزده.

- پاکسازی لینک: تفکیک لینکهای طبیعی از الگوهای مخرب؛ تماس برای حذف لینک، و استفاده محتاطانه از disavow در موارد پرخطر.

- بهبود تجربه کاربر: اصلاح ساختار هدینگها، افزودن مثالهای محلی، تصاویر اصیل و دادههای بهروز.

- بازنشر و بازایندکس: پس از اصلاح، درخواست ایندکس برای صفحات کلیدی و رصد اثر طی چند هفته.

- گزارشدهی: مستندسازی تغییرات، ثبت تاریخها و نتایج برای یادگیری سازمانی.

اگر ضربه قابلتوجه بوده، برنامه بازسازی را مرحلهبندی کنید: ابتدا صفحات اثرگذار بر درآمد، سپس خوشههای پربازدید، و در پایان بقیه صفحات.

اعتماد: سیگنالهای برند و هویت دیجیتال که الگوریتمها میپسندند

اعتماد الگوریتمی زمانی شکل میگیرد که نشانههای دنیای واقعی با محتوای شما همراستا باشد. صفحات «درباره ما»، «تماس»، نشانی فیزیکی، تیم واقعی و سیاستهای شفافیت، به فهم بهتر موتور جستوجو از اعتبار شما کمک میکند. برای یکپارچهسازی این بنیانها، از خدمات هویت دیجیتال کمک بگیرید تا سیگنالهای برندی شما مستند، قابل ارجاع و همسوتر با استانداردهای بینالمللی شوند.

اعتماد دیجیتال یعنی همخوانی «آنچه میگویید»، «آنچه نمایش میدهید» و «آنچه کاربران تجربه میکنند».

- نمایش نویسندگان با پروفایل کامل و لینک به شبکههای معتبر.

- استفاده مسئولانه از دادهها؛ ذکر روششناسی در محتوای تحقیقمحور.

- سیاستهای بازنگری محتوا و تاریخچه بهروزرسانی شفاف.

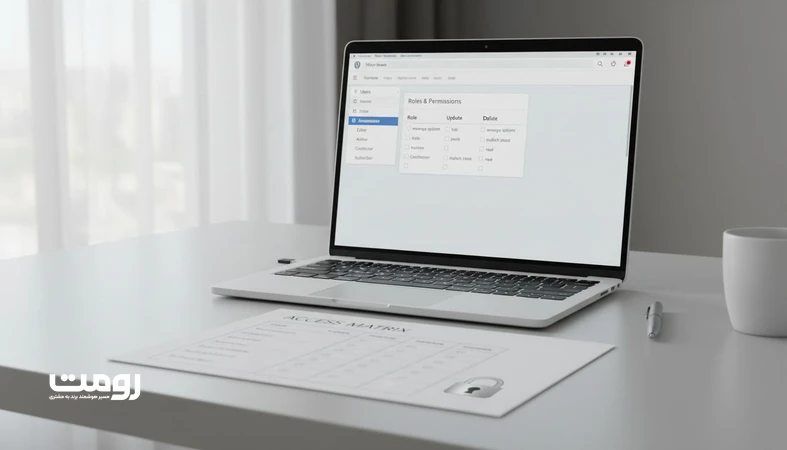

ساختار سایت، لینکسازی داخلی و کراولپذیری

یکی از کانونهای تشخیص/پیشگیری، معماری اطلاعات و ارتباط داخلی صفحات است. ساختار سالم باعث میشود خزندهها بهجای گردش در صفحات کمارزش، سریعتر به محتواهای مهم برسند؛ همچنین به الگوریتمها کمک میکند خوشههای موضوعی را درست بفهمند. اگر در فاز بازطراحی هستید، از چارچوبهای استاندارد طراحی سایت شرکتی استفاده کنید تا پایهٔ مقیاسپذیر و ضداسپم داشته باشید.

| مدل ساختار | مزیت | ریسک اسپم/اشتباه فهم | پیشنهاد |

|---|---|---|---|

| Flat (مسطح) | دسترسی سریع | ابهام موضوعی در مقیاس بالا | برای سایتهای کوچک |

| Silo (سیلویی) | وضوح خوشههای موضوعی | قفل شدن بیشازحد روی انکرهای یکسان | تنوع انکر و صفحات محوری |

| Hybrid/Graph | تعادل عمق و ارتباط افقی | نیازمند برنامهریزی دقیق | بهترین انتخاب برای رشد بلندمدت |

- هر خوشه یک صفحه «پیلار» با لینکدهی به «کلاستر»ها داشته باشد.

- انکر تکستها را طبیعی و متنوع نگه دارید؛ از کیورد استافینگ بپرهیزید.

- صفحات کمارزش (تگ/آرشیو بیهدف) را noindex کنید.

کیفیتسنجی محتوا: دادهمحور، بومیسازی و اخلاق تولید

در ۲۰۲۶، مرز بین «تولید با ابزار» و «تولید بیکیفیت» روشنتر شده است. الگوریتمها بهشدت به دنبال شواهد، نمونههای بومی و همخوانی با دادههای معتبر هستند. بنابراین، چرخه تولید باید دادهمحور باشد: تحقیق، اعتبارسنجی، نگارش انسانی/ویرایش حرفهای، و ارزیابی کیفیت.

- از مثالها، قیمتها و سناریوهای متناسب با بازار ایران استفاده کنید.

- برای محتوای تحلیلی، روش گردآوری داده را کوتاه توضیح دهید.

- از تکرار موضوعات بدون ارزش افزوده خودداری کنید؛ هر صفحه هدف یکتای خود را داشته باشد.

روندهای محتمل ۲۰۲۶: چندوجهی، زمینهمحور و مقاوم در برابر دستکاری

با گسترش تولید محتوای خودکار، تشخیص اسپم نیز چندوجهیتر شده است. انتظار میرود مدلها ترکیب سیگنالهای متنی، ساختاری و رفتاری را با ارجاع به دانشنامههای ساختیافته و الگوهای تعامل کاربر تقویت کنند. برای کسبوکارهای ایرانی، این به معنای اهمیت بیشتر «عمق تخصص»، «تناسب با زمینه محلی» و «پایش پیوسته کیفیت» است. راهبرد برد-برد این است: محتوای مسئلهمحور، استنادپذیر و تجربه کاربری سریع؛ نه بازی با الگوریتم.

جمعبندی

نبرد هوش مصنوعی در برابر اسپم، رقابتی برای اصالت و ارزشآفرینی است. در ۲۰۲۶، SpamBrain و الگوریتمهای یادگیری ماشینی با تکیه بر نشانههای زبانی، پیوندی و رفتاری، محتوای جعلی و صفحات دستکاریشده را کنار میزنند. برای پیروزی پایدار، سه اصل را نهادینه کنید: برنامهریزی دادهمحور، تولید تخصصی و ساختار فنی سالم. نتیجه، افزایش اعتماد الگوریتمی و انسانی است؛ چیزی که به رشد پایدار ترافیک و برند منتهی میشود.

برای افزایش مقاومت وبسایت خود در برابر الگوریتمهای ضداسپم، از رومت درخواست مشاوره کنید.

سوالات متداول

۱. SpamBrain دقیقاً چه چیزی را هدف میگیرد؟

SpamBrain بهدنبال الگوهای غیرطبیعی است؛ یعنی خروجیهایی که از نظر زبان، لینکسازی، رفتار کاربران و ساختار فنی با رفتار طبیعی وب فاصله دارند. تمرکز بر کیفیت و شواهد، مؤثرترین راه دوری از پرچم اسپم است.

۲. آیا محتوای تولیدشده با ابزارهای هوش مصنوعی همیشه جریمه میشود؟

خیر. مسئله کیفیت و اصالت است، نه ابزار. اگر محتوا مسئلهمحور، استنادپذیر و متناسب با نیت کاربر باشد، میتواند عملکرد خوبی داشته باشد. ویرایش انسانی و افزودن شواهد کلیدی است.

۳. بهترین گام برای بازیابی پس از افت ناگهانی چیست؟

یک ممیزی مرحلهای انجام دهید: شناسایی صفحات نازک/تکراری، پاکسازی لینکهای مشکوک، بهبود تجربه کاربر، و سپس بازنشر هدفمند. تغییرات را مستند کنید و اثر را طی چند هفته رصد کنید.

۴. چگونه لینکسازی کنیم که اسپم محسوب نشود؟

بر ارتباط موضوعی، کیفیت دامنهها و تنوع انکر تمرکز کنید. لینکهای طبیعی حاصل همکاریهای واقعی، مطالعات موردی و رفرنسدهی منطقی بهمراتب امنتر و پایدارترند تا تبادلات مصنوعی.