اگر صفحات خوبی تولید کردهاید اما در سرچ کنسول با پیغامهایی مثل «Discovered – currently not indexed» یا «Crawled – currently not indexed» روبهرو میشوید، مشکل فقط محتوا نیست؛ مسئله، ساختار است. ساختار سایت برای ایندکس گوگل به این معناست که معماری اطلاعات، لینکدهی داخلی و بهداشت فنی را طوری بچینیم که گوگل راحتتر صفحات را پیدا، خزش و ایندکس کند. در این راهنما، قدمبهقدم از معماری و عمق کلیک تا مدیریت پارامترها، Sitemap/Robots و رفع خطاهای Index Coverage را مرور میکنیم تا مسیر دسترسی رباتها به محتوا کوتاه، شفاف و قابل اعتماد شود.

ساختار سایت برای ایندکس گوگل؛ از معماری اطلاعات تا عمق کلیک

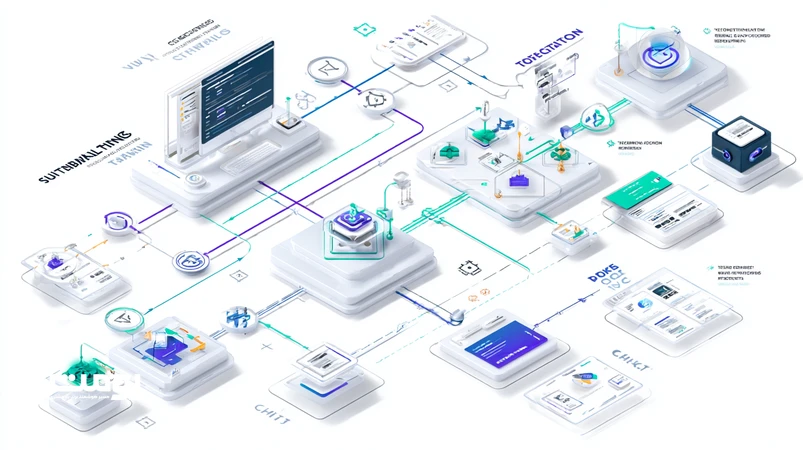

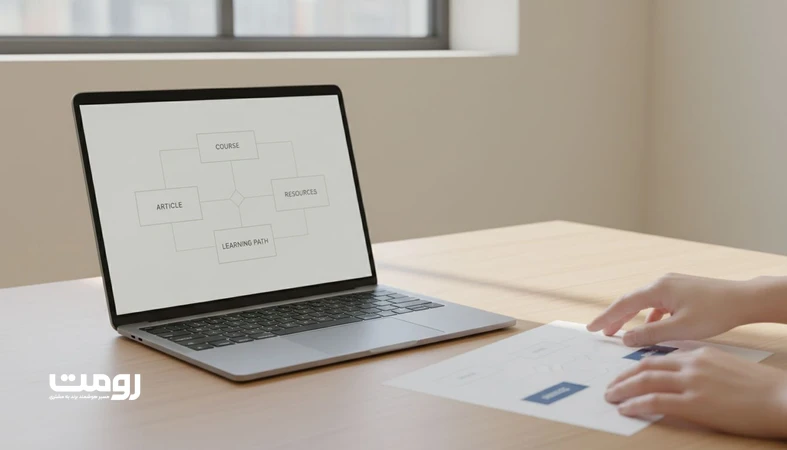

معماری اطلاعات (IA) نقشه ذهنی سایت است: چه چیزی کجاست و چگونه به آن میرسیم. هدف، کاهش ابهام برای کاربر و ربات است. یک IA خوب با خوشهبندی موضوعی (Topic Clusters) و صفحات ستون (Pillar/Hubs) شروع میشود و با پیوندهای زمینهای بین صفحات تکمیل میگردد. اصل راهبردی: بیشترین ارزش را با کمترین عمق کلیک ارائه کنید.

مدلبندی محتوا و نقشه مسیر

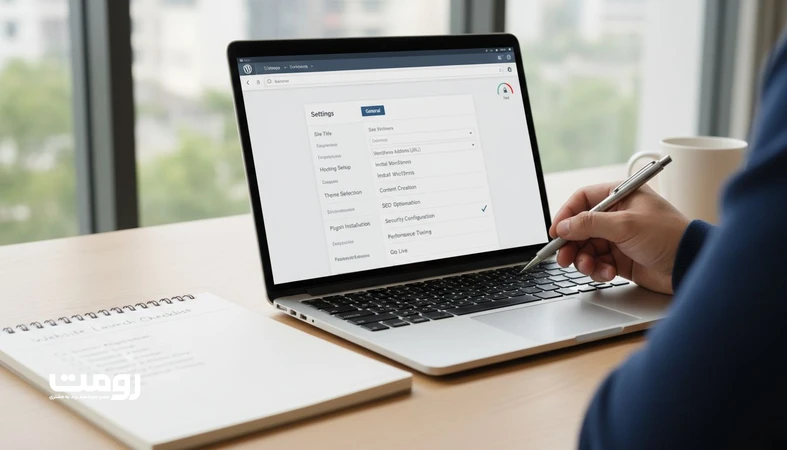

ابتدا موضوعات اصلی را به چند هاب تقسیم کنید و برای هر هاب، زیرموضوعها را به شکل شاخهای مرتب کنید. در وبسایتهای B2B، صفحههای هاب میتوانند خدمات کلیدی باشند؛ اگر در این حوزه هستید، نمونهها و چارچوب ما برای طراحی سایت شرکتی الهامبخش ساخت IA شفاف است. برای پیادهسازی سریع و منظم ساختار، استفاده از وردپرس و الگوهای از پیشتعریفشده، زمان شما را کوتاه میکند.

عمق کلیک و بودجه خزش

قانون کارا: ۸۰٪ صفحات باید در حداکثر ۳ کلیک از صفحه اصلی قابل دسترس باشند. عمق زیاد، بودجه خزش را هدر میدهد و احتمال ایندکس ناقص را بالا میبرد. استفاده از بردکرامبها، منوهای قابل اسکن و لینکهای زمینهای در پاراگرافها میتواند عمق موثر را کاهش دهد.

- صفحه اصلی ← هاب ← زیرموضوع: مسیر غالب

- از «لینکهای یتیم» پرهیز کنید؛ هر صفحه حداقل یک لینک ورودی از متن مرتبط داشته باشد.

- انکرهای معنیدار (نه «اینجا کلیک کنید»)؛ از واژههای توصیفی استفاده کنید.

اصل طلایی: اگر کاربر در دو یا سه کلیک به پاسخ میرسد، گوگل هم سریعتر به سیگنالهای کیفیت آن صفحه میرسد.

معماری URL و مدیریت پارامترها؛ تمیزی نشانیها و مهار تکثیر

URL تمیز، کوتاه و سازگار، فهم موضوع را برای کاربر و ربات آسان میکند. از حروف کوچک، خط تیره و الگوهای معنادار استفاده کنید. نشانیهای طولانی با پارامترهای متعدد (utm، sort، filter) سریعاً به محتوای همسان منجر میشوند و بودجه خزش را میبلعند.

راهنمای کاربردی پارامترها

- پارامترهای ردیابی (utm و مانند آن) را از لینکهای داخلی حذف یا به حداقل برسانید.

- برای صفحات فیلتر/مرتبسازی که ارزش ایندکس ندارند، از meta robots noindex و/یا هدر X-Robots-Tag استفاده کنید.

- وقتی محتوای پارامتری دقیقاً همان محتوای نسخه اصلی است، rel=”canonical” را به نسخه تمیز اشاره دهید.

- از Disallow در robots.txt برای پنهانکردن محتوای بیارزش استفاده نکنید اگر میخواهید «ایندکس نشود»؛ Disallow مانع خزش است نه الزاماً ایندکس. Noindex راه درست است.

هدف: هر نیت جستوجو، یک URL واحد و پایدار. از ایجاد مسیرهای متعدد به یک محتوای واحد پرهیز کنید.

Pagination، محتوای تکراری و Canonical؛ ظرافتهای صفحهبندی

صفحهبندی در وبلاگها و فروشگاهها اجتنابناپذیر است، اما تنظیمات اشتباه باعث میشود صفحات عمیقتر دیده نشوند. اشتباه رایج: canonical همه صفحات صفحهبندی شده به صفحه ۱؛ این کار سیگنالها را جمع میکند اما عملاً صفحات بعدی را از چرخه خزش خارج میسازد.

الگوی پیشنهادی صفحهبندی

- هر صفحه paginated (مثلاً ?page=2) canonical به خودش داشته باشد، مگر «صفحه مشاهده همه» واقعاً موجود و کامل باشد.

- لینک داخلی واضح به صفحات قبل/بعد در بخش بالایی و پایینی لیستها قرار دهید.

- صفحات قدیمیتر را با لینکهای زمینهای از مقالات جدیدتر تقویت کنید تا عمق موثر کم شود.

- به rel=”next/prev” تکیه نکنید؛ روی پیوندهای داخلی و ساختار منو/بردکرامب حساب باز کنید.

برای دستههایی با محتوای فراوان، یک صفحه هاب جمعبندی بسازید که بهترینها را انتخاب و به صفحات عمیقتر لینک دهد. این کار مسیرهای خزش را تراکمزدایی میکند.

Sitemap XML، Robots.txt و سیگنالهای کیفیت محتوا

Sitemap باید آینه محتوای «قابل ایندکس» باشد؛ نه انبار همه URLها. تنها URLهای ۲۰۰، کنونیکال و بدون noindex را فهرست کنید. استفاده از چند Sitemap جداگانه برای نوع محتوا (وبلاگ، محصول، صفحات) مدیریت را ساده میکند.

بهترینروشها

- lastmod دقیق بگذارید تا تغییرات زودتر دیده شوند.

- Sitemap را در robots.txt معرفی کنید و از مسدود کردن CSS/JS ضروری خودداری کنید.

- Robots.txt را مینیمال نگه دارید؛ قواعد پیچیده اغلب خطازا میشوند.

- کیفیت محتوا را با تیترهای روشن، خلاصه آغازین قوی و مدیای بهینه نشان دهید؛ سیگنالهای کیفیت، نرخ خزش و احتمال ایندکس را بهبود میدهند.

افزودن اسکیماهای متناسب (Article، Product، FAQ) درک موضوع را برای موتور جستوجو شفاف میکند. اگر به استقرار سریع اسکیما نیاز دارید، قالبها و پلاگینهای استاندارد در وردپرس راهاندازی را تسهیل میکنند.

لینکدهی داخلی هوشمند؛ از هاب و خوشه تا متنهای زمینهای

لینک داخلی سوخت موتور ایندکس است. توزیع منطقی لینکها به گوگل نشان میدهد کدام صفحات مرکزیاند و کدامها پشتیبان. یک الگوی ساده اما موثر: هر «صفحه ستون» به همه زیرموضوعها لینک بدهد و هر «زیرموضوع» هم به ستون و به دو یا سه همسایه مرتبط لینک برگرداند.

الگوهای عملی

- بردکرامب فعال با ساختار معنادار (خانه › دسته › زیرصفحه).

- جعبه «مطالب مرتبط» واقعی (بر اساس نزدیکی موضوعی، نه صرفاً تاریخ).

- انکرتکست متنوع اما دقیق؛ از تکرار مکانیکی یک کلمه کلیدی بپرهیزید.

- حذف لینکهای اضافی در فوتر که به همه صفحات میریزند و سیگنالها را رقیق میکنند.

در رومت، ما برای پروژههای بزرگ از خوشهبندی مبتنی بر معنا استفاده میکنیم تا پیشنهاد لینک داخلی را هوشمند کنیم؛ این کار هم مسیر دسترسی رباتها را کوتاه میکند و هم تجربه کاربر را بهبود میدهد.

پایش Index Coverage و رفع خطاها در Search Console

هر بهینهسازی بدون اندازهگیری ناقص است. در گزارش Page indexing، به الگوهای خطا نگاه کنید و اقدامهای اصلاحی را اولویتبندی کنید.

خطاهای رایج و راهحلها

- Discovered – currently not indexed: لینک داخلی و کیفیت محتوا را تقویت کنید؛ از صفحاتی که ایندکس شدهاند به آن لینک بدهید.

- Crawled – currently not indexed: محتوای کمعمق یا مشابه را بازنویسی/ادغام کنید و سیگنالهای کیفیت (مدیا، داده ساختاریافته) را افزایش دهید.

- Duplicate without user-selected canonical: کنونیکال صریح تعیین کنید و مسیرهای تکراری را ۳۰۱ کنید.

- Alternate page with proper canonical: اگر قصد ایندکس ندارید، وضعیت طبیعی است؛ اگر اشتباه است، کنونیکال را اصلاح کنید.

- Soft 404: پیام ارزش صفحه را تقویت و عناصر حیاتی (عنوان، متن، لینکها) را بازطراحی کنید.

- Blocked by robots.txt: اگر باید ایندکس نشود، از noindex استفاده کنید؛ اگر باید خزش شود، قانون robots.txt را بردارید.

- Server errors (5xx) / Redirect error: پایداری سرور و زنجیره ریدایرکتها را اصلاح کنید.

گزارش Crawl stats را نیز ببینید: تاخیر پاسخ، درصد خطا و حجم دانلود روزانه نشانههای مستقیمی از سلامت خزشاند. اگر رندر سمت کاربر دارید، مطمئن شوید محتوای اصلی بدون تعامل قابل مشاهده است.

چکلیست بهداشت فنی برای Crawl/Index کارآمد

- کد وضعیت درست: صفحات اصلی ۲۰۰، حذفها ۴۱۰/۴۰۴ هدفمند، جابهجاییها ۳۰۱ تکمرحلهای.

- سرعت پایدار: بهینهسازی تصاویر، فشردهسازی (Gzip/Brotli)، کش معقول و بارگذاری تنبل محتاطانه برای مدیای خارج از دید.

- Mobile-first: طرح واکنشگرا و دسترسپذیر؛ المانهای حیاتی در موبایل مخفی نشوند.

- JS قابل خزش: محتوای اصلی را سرور-ساید یا هیبریدی ارائه کنید؛ وابستگی حیاتی به تعامل کاربر برای رندر را حذف کنید.

- داده ساختاریافته معتبر: اعتبارسنجی با ابزارهای تست؛ خطاهای Schema را رفع کنید.

- نقشه مسیر خزنده: صفحه نقشه HTML و لینکهای فوتر هدفمند (نه انبوه).

- یکپارچگی محتوا: هر نیت، یک URL. ادغام و ریدایرکت صفحات کمارزش.

این چکلیست، اصطکاکهای فنی را کم میکند تا بودجه خزش به جای خطاها، صرف کشف و ایندکس صفحات ارزشمند شود.

ایندکسپذیری؛ نتیجه معماری شفاف و محتوای واضح

وقتی معماری اطلاعات روشن باشد، عمق کلیک کنترل شود و سیگنالهای فنی هماهنگ باشند، گوگل مسیر را سریع پیدا میکند و ایندکسپذیری بهبود مییابد. از تمیزی URL و مهار پارامترها تا Sitemap دقیق و لینکدهی داخلی هوشمند، هر جزء نقش خود را بازی میکند. پایش مداوم Index Coverage تضمین میکند اصلاحها به نتیجه میرسند. اگر میخواهید این مسیر را با تیمی که استراتژی، طراحی و محتوا را کنار هم میچیند طی کنید، با ما در تماس بگیرید؛ رومت این سفر را از نقشه تا فرود همراه شماست.

پرسشهای متداول

1.آیا تغییر ساختار دستهبندی، ایندکس صفحات قدیمی را بههم میزند؟

جابجایی IA اگر با برنامه انجام شود، به ایندکس آسیب نمیزند. ناوبری جدید را ابتدا شبیهسازی کنید، آدرسها را با 301 به ساختار تازه ریدایرکت کنید و نقشه سایت را بهروزرسانی کنید. لینکهای داخلی صفحات پربازدید را هم به مقصدهای جدید اصلاح کنید. چند هفته اول، Index Coverage و Crawl stats را پایش کنید تا خطاهای احتمالی مثل زنجیره ریدایرکت یا 404های ناخواسته سریع برطرف شوند.

2.عمق کلیک مناسب برای بیشتر سایتها چقدر است؟

قاعده عملی این است که هسته صفحات کسبوکاری و اکثر مقالات در حداکثر سه کلیک از صفحه اصلی قابل دسترس باشند. البته سایتهای بزرگ ناگزیرند لایههای بیشتری داشته باشند؛ در این حالت، با بردکرامب، صفحات هاب و لینکهای زمینهای، عمق «موثر» را کم کنید. اگر صفحهای ترافیک بالقوه دارد اما عمیق مانده، با لینک از صفحات قویتر آن را به سطح نزدیک کنید.

3.Canonical همه مشکلات محتوای مشابه را حل میکند؟

Canonical سیگنالی برای ادغام سیگنالها است، نه عصای جادویی. وقتی دو URL واقعاً یک محتوا را ارائه میدهند، canonical کمک میکند. اما اگر تفاوت محتوایی معنادار وجود دارد یا لینکهای داخلی به نسخههای مختلف پخش شدهاند، canonical کافی نیست. مسیر درست، یکپارچهسازی محتوا، 301 مسیرهای تکراری و سپس canonical صریح روی URL استاندارد است.

4.هر چند وقت یکبار Sitemap را بهروزرسانی کنیم؟

هر زمان صفحهای اضافه، حذف یا بهروزرسانی محتوایی معنادار انجام شد، Sitemap باید بازتاب آن را نشان دهد. برای سایتهای پرانتشار، تولید خودکار Sitemap پویا بهترین راه است. دقت کنید تنها URLهای ایندکسپذیر را وارد کنید و lastmod واقعی بگذارید. وجود URLهای 404، noindex یا ریدایرکت در Sitemap بیاعتمادی ایجاد میکند و بودجه خزش را هدر میدهد.

5.وقتی «Discovered – currently not indexed» میبینم چه کار کنم؟

این وضعیت یعنی گوگل URL را دیده اما هنوز نرفته یا نخواسته بخزد. معمولاً دلیل، کمبود سیگنالهای کیفیت یا لینکهای داخلی است. کارهای فوری: لینک از صفحات ایندکسشده مرتبط، تقویت محتوا (عنوان روشن، خلاصهی قوی، مدیای بهینه)، کاهش عمق کلیک و پاکسازی پارامترهای اضافی. اگر صفحه مشابههای زیاد دارد، ادغام و انتخاب URL استاندارد را در اولویت بگذارید.